지난 몇 달 동안 인공지능 커뮤니티는 Apple에서 발표한 두 개의 영향력 있는 연구 논문으로 인해 열띤 논쟁을 벌였습니다. 첫 번째는 ' 인공지능 세계를 뒤흔들고 있는 사고의 착각&_bhlid=a540c17e5de7c2723906dabd9b8f31cdf0c5bf18" target="_blank" id="">"GSM-Symbolic" (2024년 10월), 두 번째는 ' 인공지능 세계를 뒤흔든 논쟁의 착각'(2024년 10월)입니다, "생각의 환상" (2025년 6월)은 대규모 언어 모델의 추론 능력에 의문을 제기하며 업계 전반에 걸쳐 엇갈린 반응을 불러일으켰습니다.

이전 심층 분석에서 이미 살펴본 바와 같이 "진보의 환상: 달성하지 못한 채 시뮬레이션하는 인공 일반 지능"에서 살펴본 바와 같이, 인공 추론 문제는 우리가 기계의 지능으로 간주하는 것의 핵심을 건드린다.

Apple 연구원들은 답을 제공하기 전에 상세한 추론 추적을 생성하는 모델인 대규모 추론 모델(LRM) 에 대한 체계적인 분석을 수행했습니다. 그 결과는 놀랍고 많은 사람들에게 경각심을 불러일으켰습니다.

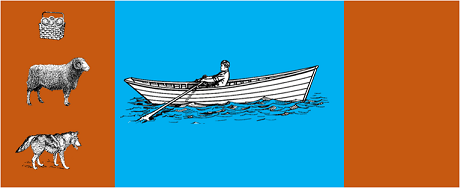

이 연구에서는 가장 진보된 모델에 다음과 같은 고전적인 알고리즘 퍼즐을 적용했습니다:

그 결과, 문제 구성의 작은 변화에도 성적이 크게 달라지는 것으로 나타나 추론의 취약성이 우려할 만한 수준임을 알 수 있었습니다. 에 보도된 바와 같이 AppleInsider 보도에 따르면 "GSM-Symbolic 벤치마크 문제의 숫자 값만 변경하면 모든 모델의 성능이 저하된다"고 합니다.

AI 커뮤니티의 반응은 그리 오래지 않아 나왔습니다. 오픈 필란트로피의 알렉스 로센은 앤트로픽의 클로드 오푸스와 공동으로 다음과 같은 제목의 반박문을 발표했습니다. "생각의 환상".Apple 연구의 방법론과 결론에 이의를 제기했습니다.

로센은 모델에 모든 수를 나열하는 대신 재귀 함수를 생성하도록 요청하는 다른 방법론으로 테스트를 반복했지만 결과는 극적으로 달라졌습니다. Claude, gemini, GPT와 같은 모델은 15개의 기록으로 하노이탑 문제를 정확하게 풀었는데, 이는 Apple이 0번의 성공을 보고했던 복잡도를 훨씬 뛰어넘는 결과였습니다.

게리 마커스는 오랫동안 LLM의 추론 능력에 대해 비판해 온 자신의 20년간의 논문을 확인한 것으로 애플의 연구 결과를 받아들였습니다. Marcus에 따르면, LLM은 '이미 해결된 문제를 잘 해결하는 사람'으로 남으면서도 학습 데이터를 넘어 일반화하는 능력인 '분포 전환'에 계속 어려움을 겪고 있다고 합니다.

이 논의는 다음과 같은 전문 커뮤니티로도 확산되었습니다. Reddit의 LocalLlama와 같은 전문 커뮤니티에서도 개발자와 연구자들이 오픈 소스 모델과 로컬 구현에 대한 실질적인 의미에 대해 토론하고 있습니다.

이 논쟁은 순전히 학문적인 것이 아닙니다. 이 논쟁은 다음과 같은 분야에 직접적인 영향을 미칩니다:

몇 가지 기술 인사이트에서 강조했듯이 기술적 인사이트에서 강조했듯이, 두 가지를 결합한 하이브리드 접근 방식에 대한 필요성이 점점 더 커지고 있습니다:

간단한 예: 장부를 도와주는 AI 어시스턴트. 언어 모델은 "이번 달 여행에 얼마를 지출했나요?"라고 질문하면 이를 이해하고 관련 매개변수(카테고리: 여행, 기간: 이번 달)를 추출합니다. 하지만 데이터베이스를 쿼리하고 합계를 계산하고 재정적 제약 조건을 확인하는 SQL 쿼리는 어떻게 할까요? 이는 신경 모델이 아닌 결정론적 코드에 의해 수행됩니다.

애플의 논문이 WWDC 직전에 발표되어 전략적 동기에 대한 의문이 제기된 것은 관찰자들의 주목을 피할 수 없었습니다. 9to5Mac의9to5Mac의 분석의 분석에서 알 수 있듯이, "WWDC 직전에 애플 논문이 발표된 시기는 많은 의문을 불러일으켰습니다. 이것이 연구의 이정표였을까요, 아니면 더 넓은 AI 환경에서 Apple의 위치를 재조정하기 위한 전략적 움직임이었을까요?"

애플의 논문으로 촉발된 논쟁은 우리가 아직 인공지능을 이해하는 초기 단계에 있다는 사실을 상기시켜 줍니다. 저희의 이전 글에서 지적했듯이 시뮬레이션과 실제 추론의 구분은 여전히 우리 시대의 가장 복잡한 과제 중 하나입니다.

진정한 교훈은 인공 지능이 인간적 의미의 '추론'을 할 수 있는지 여부가 아니라, 인공 지능의 한계를 보완하면서 강점을 활용하는 시스템을 어떻게 구축할 수 있는지에 관한 것입니다. AI가 이미 모든 분야를 혁신하고 있는 지금, 문제는 더 이상 이러한 도구가 '스마트'한지 여부가 아니라 이를 어떻게 효과적이고 책임감 있게 사용할 수 있는지가 되었습니다.

엔터프라이즈 AI의 미래는 하나의 혁신적인 접근 방식이 아니라 여러 상호 보완적인 기술의 지능적인 오케스트레이션에 있을 것입니다. 그리고 이러한 시나리오에서는 도구의 기능을 비판적이고 정직하게 평가하는 능력 자체가 경쟁 우위가 될 것입니다.

최신 동향 (2026년 1월)

OpenAI, o3 및 o4-mini 공개: 2025년 4월 16일, OpenAI는 o 시리즈 중 가장 진보된 추론 모델인 o3 및 o4-mini를 공개했습니다. 이 모델들은 이제 웹 검색, 파일 분석, 시각적 추론 및 이미지 생성을 결합하여 도구들을 능동적으로 활용할 수 있습니다. o3는 Codeforces, SWE-bench, MMMU와 같은 벤치마크에서 새로운 기록을 세웠으며, o4-mini는 대량 추론 작업에 대한 성능과 비용을 최적화합니다. 이 모델들은 '이미지로 생각하는' 능력을 보여주며, 더 심층적인 분석을 위해 콘텐츠를 시각적으로 변환합니다.

DeepSeek-R1, AI 산업을 뒤흔들다: 2025년 1월, DeepSeek은 오픈소스 추론 모델인 R1을 출시했습니다. 이 모델은 OpenAI o1과 비교 가능한 성능을 달성했으며, 훈련 비용은 단 600만 달러에 불과했습니다(서양 모델들의 수억 달러 대비). DeepSeek-R1은 인간이 주석 처리한 데모 없이도 순수 강화 학습을 통해 추론 능력을 향상시킬 수 있음을 입증했습니다. 이 모델은 수십 개 국가의 앱 스토어와 구글 플레이에서 무료 앱 1위를 차지했습니다. 2026년 1월, DeepSeek는 60페이지 분량의 확장 논문을 발표하며 훈련의 비밀을 공개하고, 몬테카를로 트리 서치(MCTS) 같은 기법이 일반적 추론에는 효과가 없었다고 솔직히 인정했습니다.

Anthropic, Claude의 '헌법' 업데이트: 2026년 1월 22일, Anthropic은 규칙 기반 접근 방식에서 윤리적 원칙 이해 기반 접근 방식으로 전환하며 Claude를 위한 23,000단어 분량의 새로운 헌법을 발표했습니다. 이 문서는 AI의 의식 가능성 또는 도덕적 지위를 공식적으로 인정하는 대형 AI 기업의 첫 번째 프레임워크가 되었으며, Anthropic이 Claude의 "심리적 안녕, 자아 인식 및 복지"를 중시한다고 명시하고 있습니다.

논쟁이 격화되고 있다: 2025년 7월 연구는 애플의 벤치마크를 재현하고 정교화하여, LRM이 복잡성이 중간 정도 증가할 때(한노이 탑의 약 8개 원반 수준) 여전히 인지적 한계를 보인다는 점을 확인했다. 연구진은 이것이 단순히 출력 제약 때문이 아니라 실제 인지적 한계에 기인함을 입증하며, 논쟁이 아직 끝나지 않았음을 강조했다.

조직의 AI 전략에 대한 인사이트와 강력한 솔루션 구현을 위해 전문가 팀이 맞춤형 컨설팅을 제공합니다.